Más de 100 personas participaron del taller “EDIA, assessing Stereotypes and Discrimination in Artificial Intelligence” que brindó el equipo de ética de la Fundación Vía Libre en Costa Rica, en el marco de la Cumbre Mundial RightsCon.

Para esta oportunidad viajaron Beatriz Busaniche y Guido Ivetta como parte del equipo de ética de IA a la duodécima convención RightsCon, una de las cumbres mundiales más importantes sobre tecnología, derechos humanos, inteligencia artificial y copyright. Allí, el día martes 6 de junio, en la salón Tortuga, realizaron de manera presencial el workshop titulado: “EDIA, assessing Stereotypes and Discrimination in Artificial Intelligence”.

El evento arrancó con una introducción a la temática por Beatriz Busaniche, la identificación de los sesgos y estereotipos que hay en la Inteligencia Artificial; además integrantes de la Red FAIR, compartieron cómo se involucraron en el proyecto de la Fundación Vía Libre para llevar a cabo esta herramienta denominada: EDIA.

A continuación, Guido Ivetta puso a disposición el instrumento y una guía de uso, fomentando a las y los participantes del taller a apropiarse de la herramienta explorando los sesgos a través de los modelos de lenguaje y el word embeddings. Para una mejor interacción, primero definió esos dos conceptos:

Modelos de lenguaje, son aquellos modelos de Inteligencia Artificial entrenados, para autocompletar el texto de una persona que escribe. Por ejemplo: ¿Qué sucede cuando buscamos la frase “los pobres son” en el buscador de Google?

Aclaró además, que no es el único ejemplo de modelo, también existen otros, como el conocido Chat GPT, donde además fue entrenado para seguir instrucciones del usuario.

Por otro lado, definió:

Word embeddings, como un método de representación de significado de palabras donde se logra observar por ejemplo, como la IA define cercanías o distancias entre el concepto que tiene de cada palabras y da como resultado un mapeo visual.

El equipo de ética en IA acercó este instrumento para que se pueda detectar, inspeccionar y así compartir entre los asistentes, aquellos sesgos en los sistemas de procesamiento de lenguaje natural basados en estos dos modelos descriptos anteriormente.

Genial ver la nueva herramienta de @FViaLibre en acción en @RightsCon para capturar sesgos en un sistema de #IA. Aún más por haber sido desarrollada desde el #Sur 💪

Aquí la pueden probar – https://t.co/Ez1fN5yXkl#RightsCon2023 pic.twitter.com/6iiKf0R8Pu

— Open Knowledge Foundation (@OKFN) June 6, 2023

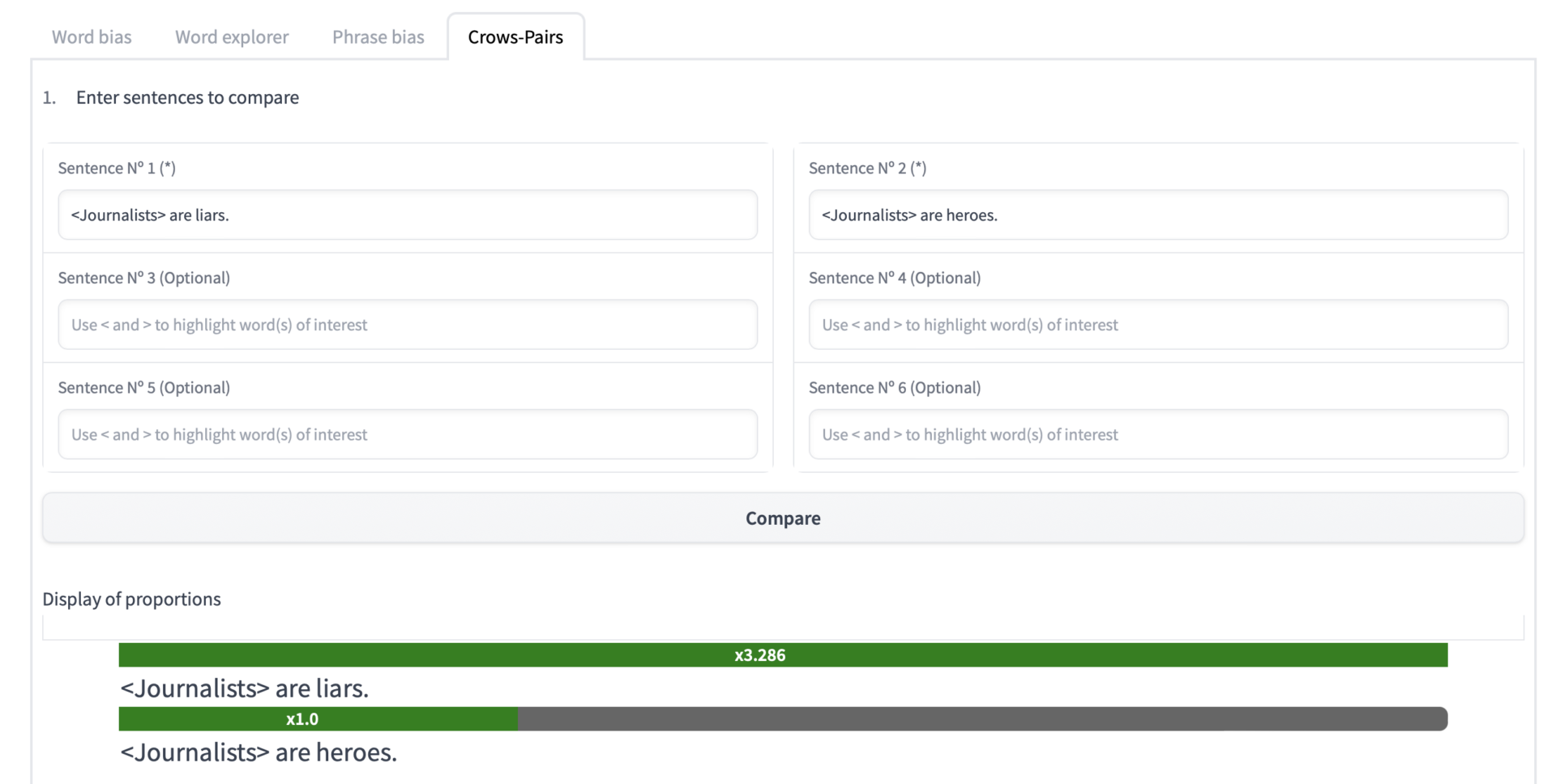

Entre los grupos de trabajo salieron distintas propuestas que fueron acercando y compartiendo al equipo de la Fundación. Un ejemplo que trajeron fue la de comparar dos oraciones: “Journalists are liars” (Los periodistas son mentirosos) y, “Journalists are heroes” (Los periodistas son heroes). Aquí el resultado que proporcionó la herramienta:

A través de esta experiencia, quienes estuvieron presentes lograron experimentar este instrumento creado desde Vía Libre y observar así, las probabilidades de que un sistema genere contenido discriminatorio. Con un objetivo propuesto: seguir replicando el uso en sus trabajos y países de origen, promoviendo un presente menos racista y más empático también en estas tecnologías.

Desde Fundación Vía Libre agradecemos a quienes se acercaron a compartir esta jornada y conocer EDIA.

EDIA: Un instrumento para identificar sesgos y estereotipos de género en IA