Durante el fin de semana, en Twitter comenzaron a circular múltiples ejemplos de diversos usuarios que mostraban cómo el algoritmo de Twitter que selecciona qué parte de una imagen muestra en la vista previa del timeline (TL) de los usuarios favorecía a los rostros de personas blancas sobre las de personas negras. Es decir que, entre ambos rostros, en las imágenes previas se muestran con mayor frecuencia a los de personas blancas.

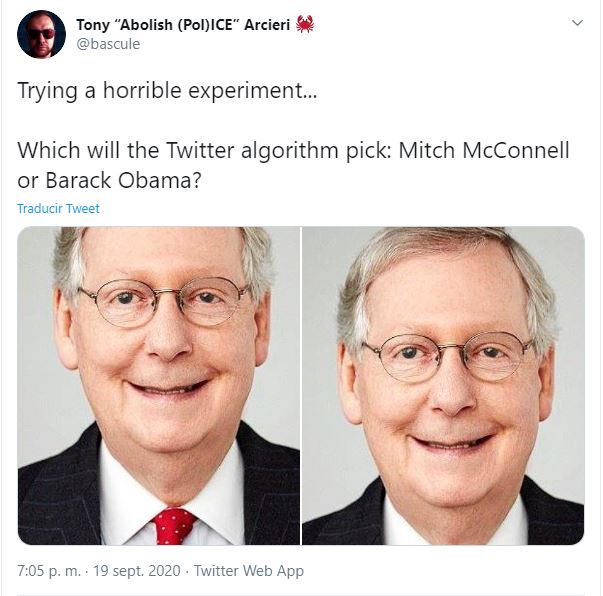

El sábado 19 de septiembre, el Ingeniero en Criptografía e Infraestructura, Tony Arcieri, publicó un hilo en Twitter con lo que él llamó un “horrible experimento”. En el primer tuit, comparó las imágenes del senador republicano Mitch McConnell con las del ex presidente Barack Obama, y el resultado fue que en la imagen previa sólo se veía al senador.

Trying a horrible experiment…

— Tony “Abolish (Pol)ICE” Arcieri 🦀 (@bascule) September 19, 2020

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

El domingo, Liz Kelley, miembro del equipo de comunicaciones de Twitter, respondió: “Gracias a todos los que plantearon esto. Hicimos pruebas de sesgo antes de enviar el modelo y no encontramos evidencia de sesgo racial o de género en nuestras pruebas, pero está claro que tenemos más análisis para hacer. Abriremos nuestro trabajo para que otros puedan revisarlo y reproducirlo.”

thanks to everyone who raised this. we tested for bias before shipping the model and didn’t find evidence of racial or gender bias in our testing, but it’s clear that we’ve got more analysis to do. we’ll open source our work so others can review and replicate. https://t.co/E6sZV3xboH

— liz kelley (@lizkelley) September 20, 2020

El hecho de que las decisiones de un algoritmo no sean intencionalmente racistas no significa que no tenga sesgos raciales en la práctica. Sin embargo, tanto el Director de Diseño de Twitter, Dantley Davis, como el Director de Tecnología, Parag Agrawal, también intervinieron en Twitter para decir que, aunque se hicieron las pruebas es evidente que deben seguir “investigando” la red neuronal (neural network, en inglés).

Las pruebas públicas de comparación de imágenes siguieron sucediendo a lo largo del fin de semana y días subsiguientes. Algunas personas comentaron que lo que posiblemente haga el algoritmo sea priorizar a las imágenes que tengan mayor contraste de colores.

Leí que se guía por el contraste de colores y me parece una mejor explicación (? pic.twitter.com/lpUxXNWd7q

— Cuarentennial (@Gowther0_0) September 21, 2020

Es positivo que la respuesta general de Twitter al experimento hecho por múltiples usuarios haya sido que van a investigar su red neuronal y, de acuerdo con la promesa de Liz Kelley, que abrirán su trabajo para que otras personas puedan estudiarlo. Para evaluar el sesgo, los investigadores necesitan un tamaño de muestra grande con múltiples ejemplos en una variedad de circunstancias y realizar un análisis riguroso.

Los múltiples ejemplos de las vistas previas de imágenes de Twitter podrían ser un ejemplo de sesgo algorítmico, que es el que se da cuando los sistemas automatizados reflejan los sesgos de sus creadores humanos o toman decisiones que tienen implicaciones sesgadas.

En 2018, Twitter publicó un post en el blog que explicaba cómo usaba una red neuronal para tomar decisiones sobre vistas previas de fotos. Uno de los factores son los niveles de contraste más altos, lo que podría explicar por qué el sistema parece favorecer las caras blancas. La decisión de utilizar el contraste como factor determinante puede no ser intencionalmente racista, pero mostrar con mayor frecuencia rostros blancos que negros es un resultado sesgado.