Por Beatriz Busaniche, Fundación Vía Libre.

La resolución 710/2024 que crea la Unidad de Inteligencia Artificial Aplicada a la Seguridad (UIAAS) no sólo está plagada de problemas jurídicos sino que promete realizar acciones para las que jamás deberíamos usar inteligencia artificial.

El documento publicado el 26 de julio en el Boletín Oficial y que lleva la firma de la Ministra de Seguridad Patricia Bullrich construye un marco de aplicación de sistemas de IA para predicción de crimen, perfilado de personas, análisis de casos y detección de fraude entre otras acciones. No hay en la resolución ningún reaseguro de legalidad y debido proceso en la aplicación de estas tecnologías, se desconoce el tipo de herramientas a utilizar, los proveedores y los mecanismos de contralor para las mismas.

La resolución es una forma burda de ocultar un avance desproporcionado e inaceptable sobre las libertades civiles escondida bajo la bruma de una promesa tecnológica carente de todo fundamento. Analizada en su legalidad, lo que propone la Ministra de Seguridad está reñido con los principios de la ley de inteligencia. Pese a que no se la presenta como un organismo para ese fin, las funciones de la UIAAS también califican como inteligencia y por lo tanto quedan comprendidas en la prohibición expresa de “obtener información, producir inteligencia o almacenar datos sobre personas, por el solo hecho de su raza, fe religiosa, acciones privadas, u opinión política, o de adhesión o pertenencia a organizaciones partidarias, sociales, sindicales, comunitarias, cooperativas, asistenciales, culturales o laborales, así como por la actividad lícita que desarrollen en cualquier esfera de acción” tal como queda claramente definido en el artículo 4to. De la ley 25.520.

En el marco de la Ley de Protección de Datos Personales, este tipo de políticas afectan el efectivo ejercicio de los derechos tutelados y muy especialmente el derecho fundamental a ser dejados en paz y a opinar libremente. Este tipo de monitoreo tiene además la capacidad de generar condiciones de autocensura y autoexclusión del espacio de debate público digital.

A esto podemos sumar un reciente fallo de la Corte Interamericana de Derechos Humanos que, en el caso Miembros de la Corporación Colectivo de Abogados “José Alvear Restrepo” Vs. Colombia juzgó y condenó a ese Estado por intromisiones ilegales en la vida privada de las víctimas. La Corte IDH declaró que Colombia vulneró los derechos a la vida, a la integridad personal, a la vida privada, a la libertad de pensamiento y de expresión, a la autodeterminación informativa, a conocer la verdad, a la honra, a las garantías judiciales, a la protección judicial, a la libertad de asociación, de circulación y de residencia, a la protección de la familia, los derechos de la niñez y el derecho a defender los derechos humanos.

Es, además, la puerta a una serie de negocios de compra de tecnologías de vigilancia que todavía no estamos en condiciones de cuantificar.

Ciberpatrullaje con IA

En una resolución anterior, la 428/2024, el Ministerio anunciaba una nueva etapa en su política de vigilancia e inteligencia de fuentes abiertas. En este caso, la creación de esta unidad de IA pone bajo su órbita la realización de esas tareas de forma automatizada con la utilización de sistemas de aprendizaje automático.

La falta de proporcionalidad de esta medida es evidente. Para que un sistema automatizado de este tipo arroje algún resultado, primero debe ser entrenado con un volumen inmenso de datos que incluyen datos personales de la ciudadanía, opiniones, expresiones y todo tipo de texto publicado en redes sociales de fuente abierta.

Vale enfatizar que, más allá de que las opiniones volcadas en una red social sean públicas, las personas tienen un derecho a la privacidad, la protección de sus datos personales y la preservación de su autodeterminación informativa. En resumen, que algo sea público no habilita la recolección, el procesamiento y el uso de estos datos para el entrenamiento de sistemas de IA ni mucho menos el perfilamiento, especialmente cuando se trata de datos personales protegidos en Argentina con el más alto nivel constitucional.

Los sistemas de IA funcionan de forma probabilística con márgenes de error variables y conllevan fuertes sesgos que suponen casos de discriminación contra poblaciones históricamente vulneradas. Son sistemas estocásticos, es decir, evolucionan de manera impredecible pero con una secuencia que se puede analizar de forma probabilística. Es estadística y azar reunido en un proceso computacional. Eso puede funcionar de forma sorprendente cuando jugamos con algún modelo de lenguaje como ChatGPT o cuando hacemos música con IA, pero si se trata de tomar decisiones sobre la seguridad y la vigilancia de la ciudadanía se vuelve algo muy serio.

Vale aclarar que la investigación criminal está fuertemente regulada por procedimientos que atienden el debido proceso y la protección de las garantías constitucionales. Estos sistemas no son transparentes a la hora de tomar decisiones, no exponen con claridad las razones por las cuales levantaron una alerta sobre un determinado discurso o persona y por lo tanto no se deberían usar para labores de vigilancia y seguridad.

Perfilamiento o sentencia previa

En la flamante normativa de regulación de la inteligencia artificial de la Unión Europea, los sistemas de perfilamiento de las personas están incluidas dentro de la clasificación de riesgo inaceptable para la seguridad, los medios de vida y los derechos de las personas. Mecanismos de puntuación social como los que existen en China (referencia citada en la resolución del gobierno nacional) o manipulación del comportamiento humano que causan daños están estrictamente prohibidas.

Con ese antecedente, la resolución integra el objetivo de “procesar grandes volúmenes de datos de diversas fuentes para extraer información útil y crear perfiles de sospechosos o identificar vínculos entre diferentes casos” como una de las tareas de esta unidad. En este contexto, la IA utiliza grandes volúmenes de datos para construir modelos que pueden predecir comportamientos o clasificar a los individuos según características específicas, en este caso, perfiles sospechosos.

La creación de perfiles a vigilar específicamente a partir de lo que ocurra en las redes sociales es definitivamente un abuso desproporcionado de autoridad por parte del Ministerio de Seguridad. Ni hablar de la investigación de las personas sin una causa judicial que así lo justifique.

Se agrega a esto un inciso donde se incluye el objetivo de “analizar actividades en redes sociales para detectar amenazas potenciales, identificar movimientos de grupos delictivos o prever disturbios”, esencialmente se pondrá bajo la lupa a cualquier persona que llame a una movilización u organice una protesta, bloqueando así el derecho constitucional a la libertad de expresión y la protesta social.

Reaseguros inexistentes

Más allá de la mención a la constitución y la legislación vigente, la resolución no integra ningún elemento que permita imaginar siquiera un mínimo control sobre la utilización por parte de las fuerzas de seguridad federales de estas tecnologías. No hay prevista ninguna auditoría, ningún análisis de impacto ni una política de seguimiento y contralor de las mismas.

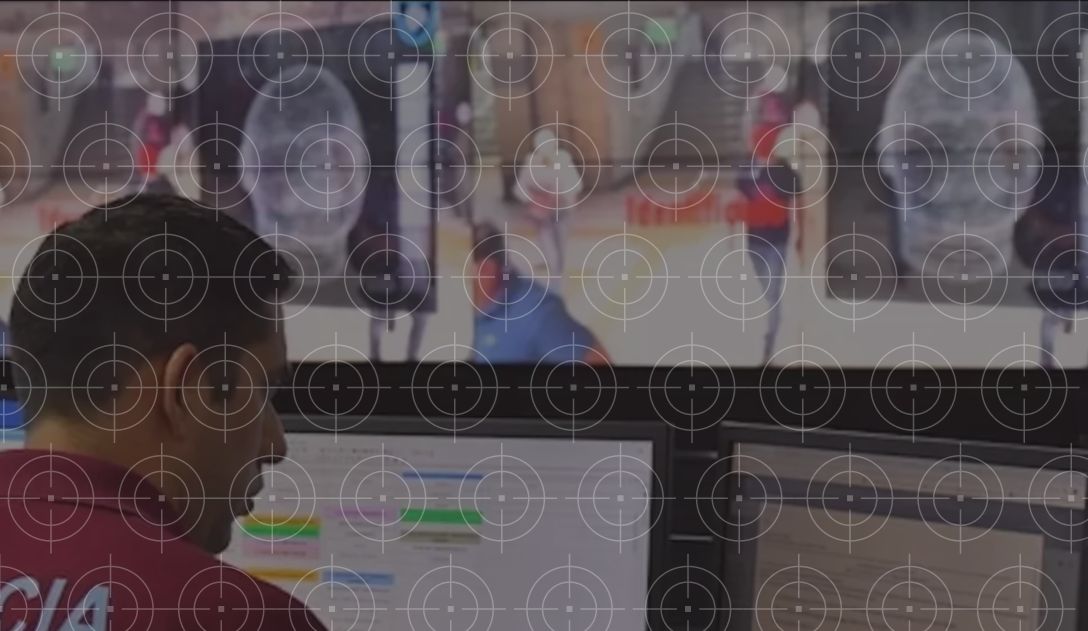

Vale mencionar que uno de los objetivos previstos, el de monitorear el espacio público usando cámaras de vigilancia y sistemas de reconocimiento facial, no sólo está prohibido en ciudades importantes de Occidente como Boston o San Francisco, sino que está bloqueado el uso de estos sistemas en la propia ciudad autónoma de Buenos Aires. Aquí, la justicia tiene suspendido el uso con un fallo firme hasta tanto la ciudad y la empresa proveedora cumplan con pautas básicas de transparencia y auditabilidad de los sistemas.

Un negocio redondo

Cuando nos preguntamos para qué quieren todo esto, hay al menos dos elementos que emergen como explicación. El primero es la propaganda política y la idea de mostrar un gobierno innovador que, a tono con la época, pone inteligencia artificial a todo sin sopesar riesgos ni costos.

Pero la segunda y más significativa es el negocio detrás de la compra de estas tecnologías. Se trata de sistemas costosos, provistos por empresas específicas sin competencia en un mercado donde la compulsa de precios es más una excepción que una regla. Sin comparativos de mercado, sin oferta pública, sin parámetro de cómo funcionan y cómo están hechos estos sistemas, la compra de estos productos es ideal para invertir enormes presupuestos por compra directa, sin auditoría ni control.