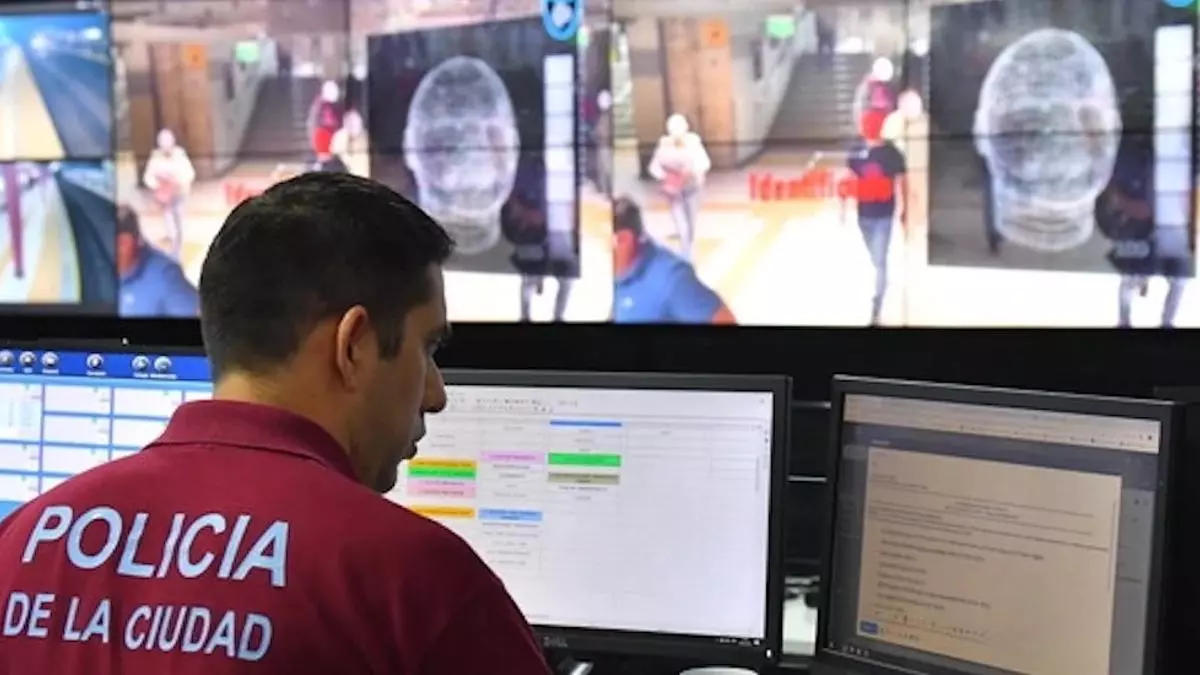

El sistema fue implementado por el Gobierno porteño para identificar prófugos de la Justicia pero, entre otras cosas, sirvió para vigilar a personas públicas y se nutrió de datos de personas sin antecedentes. Está suspendido, pero este miércoles habrá una audiencia para definir las condiciones bajo las que podría reanudarse.

La Ciudad Autónoma de Buenos Aires se encuentra ante la oportunidad inusual de establecer un estándar apropiado de control de los sistemas de reconocimiento facial en la vía pública. El próximo miércoles se realizará una audiencia de ejecución de sentencia en los tribunales porteños, de allí saldrán las pautas para controlar el sistema de vigilancia más invasivo del país.

El caso del Sistema de Reconocimiento Facial en Buenos Aires ganó enorme notoriedad hace un par de años, cuando saltó a la luz que el sistema que había implementado la Ciudad Autónoma de Buenos Aires en 2019 había sido usado para acceder a información de personas públicas, entre ellas, periodistas (Gustavo Sylvestre, Eduardo Feinmann, entre otros), políticos de todos los colores partidarios (Cristina Fernández de Kirchner, Alberto Fernández, José Luis Espert, Gerardo Morales, Javier Milei, entre otros) así como activistas de organizaciones sociales como Estela de Carlotto. También fueron obtenidos de forma irregular los datos biométricos de integrantes de la Corte Suprema de Justicia como Carlos Rosenkrantz. La lista es larga y variopinta, y permite documentar el hecho de que los sistemas de reconocimiento facial de este tipo son peligrosos para la intimidad, la seguridad y las garantías de la ciudadanía. El gobierno de la Ciudad fue intimado por la justicia a dar explicaciones, que siempre fueron vagas e insuficientes.

Nada de esto se hubiera conocido sin la atinada acción judicial que presentaron en forma conjunta el Observatorio de Derecho Informático Argentino (ODIA) y el Centro de Estudios Legales y Sociales (CELS). Ambas organizaciones se constituyeron como actoras para evitar la implementación del sistema de reconocimiento facial en CABA. La Fundación Vía Libre se integró a la causa como amiga del tribunal y presentó numerosos argumentos para apoyar la acción de sus colegas.

La causa tuvo sus vaivenes, pero finalmente se logró suspender el uso del sistema mediante un fallo de primera instancia, confirmado por otro de Cámara, que le ordenaron a la Ciudad de Buenos Aires cumplir con una serie de requisitos antes de reinstalar esta forma de monitoreo del espacio público. Entre los requisitos se le exige al Gobierno de la Ciudad someter el sistema a una auditoría, establecer los mecanismos de control que dicta la norma vigente en la ciudad y realizar una evaluación de impacto en la privacidad del sistema. Esta última medida fue uno de los requerimientos que hizo en su visita a Buenos Aires el relator de ONU para la Privacidad, quien consideró que un sistema de esta naturaleza no puede ni debe implementarse sin una detallada y exigente evaluación de su impacto en derechos humanos.

¿Quién vigila al vigilante?

El sistema de reconocimiento facial para la identificación de prófugos en CABA fue impulsado por quien entonces ejercía el doble rol de ministro de Seguridad y vicejefe de Gobierno, Diego Santilli. Presentado con bombos y platillos y sin consulta previa a la Legislatura, el Gobierno de la Ciudad contrató de forma directa los servicios de una empresa llamada Danaide, proveedora del software de reconocimiento facial que se instaló en unas 300 cámaras del parque de vigilancia de la ciudad.

En su momento generó diversos problemas, entre ellos varios falsos positivos que derivaron en detenciones arbitrarias. Otro problema grave fue que se realizó una implementación sin que mediara debate ni regulación alguna de contralor de una tecnología que para esa fecha ya estaba prohibida en grandes ciudades del mundo como Boston o San Francisco.

En ese contexto, ODIA y el CELS se presentaron ante la justicia para reclamar contra el sistema. En paralelo, la Legislatura sancionó una norma que fue propuesta por la diputada Claudia Neira (del Frente de Todos) y que fue votada en contra por su propio partido para dar luz verde a la implementación. La legislatura resolvió así que dos órganos se ocupen del control: una comisión especial de la Legislatura y la Defensoría del Pueblo de la Ciudad Autónoma de Buenos Aires.

El sistema de reconocimiento facial funciona en base a grandes volúmenes de datos. Como todo sistema de inteligencia artificial, está entrenado con un gran número de imágenes para identificar de forma probabilística una persona entre los miles de rostros que pasan frente a las cámaras en el espacio público. En teoría, el sistema debería identificar a las personas buscadas por la Justicia. Así se lo presentó en primera instancia, como un sistema automatizado para encontrar prófugos.

Sin embargo, los allanamientos y la investigación llevada adelante por la Justicia determinaron que el sistema había sido usado de forma irregular, que se habían obtenido millones de datos de la base de datos de RENAPER de personas sin antecedentes penales que habían sido incorporadas al sistema.

La orden ahora es auditar ese sistema como condición fundamental para autorizar su utilización. A la fecha, el sistema está suspendido.

Las organizaciones que seguimos esta causa hemos insistido en que estos sistemas no deben utilizarse por su alto riesgo y por el grave impacto que generan a la sociedad. Ahora nos toca discutir cuáles serían las condiciones para una eventual evaluación de los mismos. Auditar un sistema de este tipo es costoso, pero mucho más costoso es privar a la ciudadanía de derechos fundamentales, especialmente en momentos de alta conflictividad social en los que la protesta social está siendo criminalizada y se amenaza a las personas que se movilizan en defensa de sus derechos.

Se puede optar por una solución de compromiso que suponga una auditoría liviana, decorativa, inocua para la empresa y el Gobierno de la Ciudad. Una auditoría que no audite nada.

El próximo miércoles, en la audiencia, vamos a demandar un sistema de control apropiado para estas tecnologías, que se pueda conocer cómo funciona el sistema, con qué datasets fue entrenado, su arquitectura y toda la información esencial para controlar adecuadamente un sistema de esta naturaleza. Auditar sistemas de inteligencia artificial es complejo pero no imposible, y en Argentina existen las condiciones científicas y tecnológicas para hacerlo.

Si la empresa no entrega toda la información para una buena auditoría y el Gobierno de la Ciudad no presenta todos los protocolos de seguridad, el reconocimiento facial no debería volver a la Ciudad de Buenos Aires.

En otra oportunidad podríamos avanzar sobre la opacidad del proceso de compra directa de un sistema que ni el propio Gobierno porteño sabe exactamente cómo funciona. Esa también es una de las demandas que llevaremos a la audiencia del próximo miércoles.

La autora es presidenta de la Fundación Vía Libre.