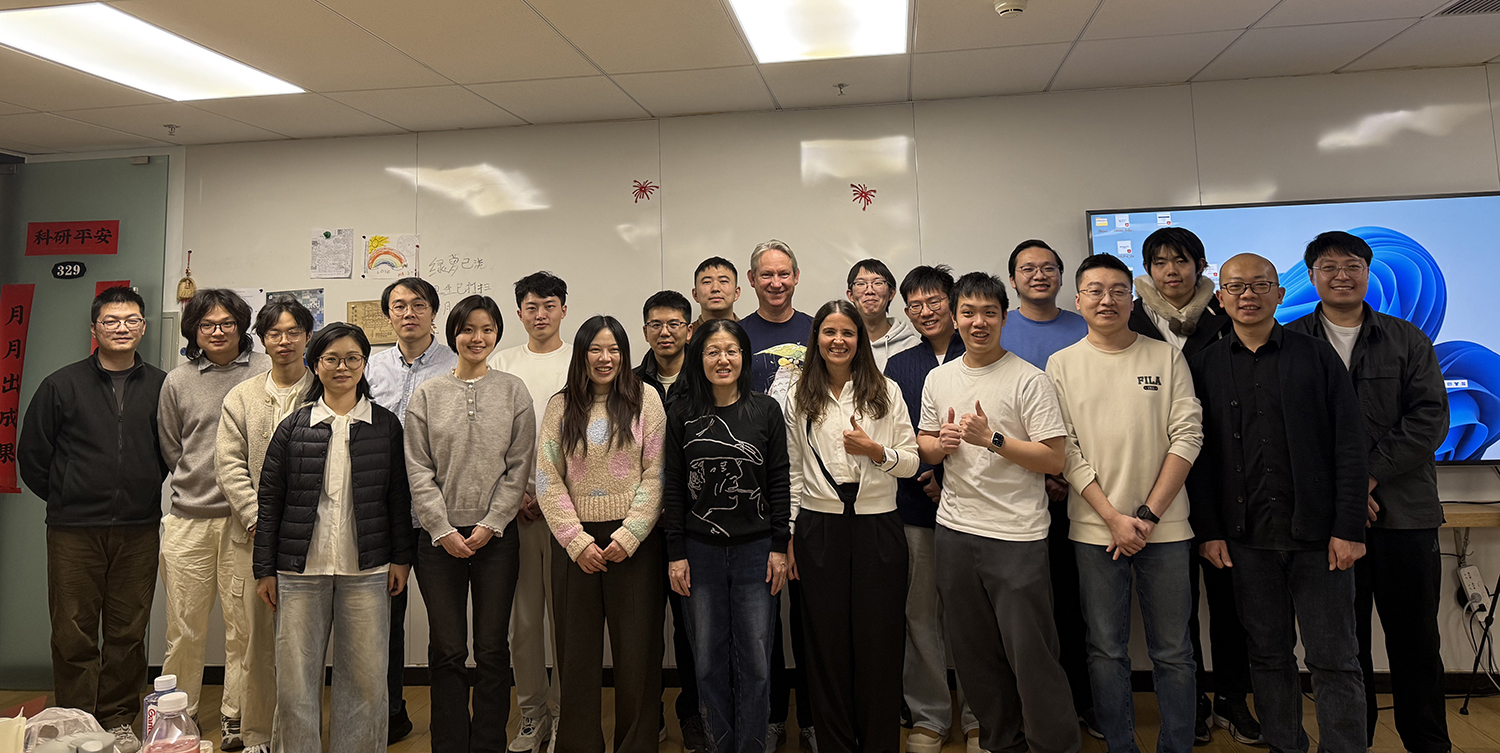

El 12 de enero, se desarrolló un seminario en la Universidad de Tsinghua (China) a cargo de Luciana Benotti. Durante el seminario, titulado: Estereotipos en modelos de lenguaje que “razonan”, se trabajó con un grupo reducido de estudiantes de maestría y doctorado, junto a docentes e investigadores de distintas universidades cercanas, se recolectaron ejemplos de estereotipos y se testeó la herramienta EDIA en idioma chino.

Uno de los ejes que surgió con más fuerza durante el seminario fue el análisis del estereotipo “996”, que remite a la jornada laboral allí de 9 a 9 hs y 6 días a la semana. La perspectiva por la cual se exploró como un estereotipo es que está muy relacionado a la narrativa que tiene Estados Unidos de por qué China está ganando o compitiendo en la carrera tecnológica y el modo en que pasó de ser conocida como “la fábrica de cosas de baja calidad” a liderar en IA y en otras tecnologías, como el 5G. Esta narrativa crea la idea de que su avance se debe principalmente a jornadas laborales extremas y no a capacidades intelectuales, creatividad o decisiones estratégicas. Si bien existen prácticas reales que alimentan esta percepción, el debate permitió problematizar cómo este tipo de explicaciones terminan minimizando el papel central de la inversión sostenida en educación, ciencia y tecnología, así como de la planificación estatal y el talento de quienes desarrollan estas tecnologías. Estos estereotipos no solo simplifican procesos complejos: también deshumanizan. Presentan a la sociedad de China como una “máquina de trabajo”, invisibilizando que detrás del desarrollo tecnológico hay personas, creatividad, deseos y proyectos de vida.

Desde Vía Libre venimos trabajando sobre cómo los modelos de lenguaje reflejan estereotipos externos (los que una sociedad produce sobre otra) e internos (los que una comunidad tiene sobre sí misma), y cómo estas diferencias suelen perderse cuando los sistemas se entrenan sobre datos ocultos y no auditables.

Como señaló Luciana Benotti:

“Uno de los temas de mayor interés es ver los estereotipos reflejados en los modelos de lenguaje como una vía de estudiar a la sociedad y de encontrar pruebas de que ese estereotipo existe en los datos. El obstáculo para ésto es que la mayor parte de los modelos de lenguaje grandes actuales, los que incluyen más información, no sabemos en qué datos están entrenados, entonces, no sabemos bien los estereotipos de quién están reflejando.”

En ese sentido, el intercambio abrió discusiones profundas sobre los límites actuales para estudiar los sesgos de los LLMs comerciales y la importancia de impulsar modelos entrenados con datos abiertos y contextualizados.

Luciana rescató también la mirada positivista que se tiene en China con respecto a la inteligencia artificial, de usarla realmente para ahorrar trabajo o para hacer el trabajo más fácil y no necesariamente para pagarles menos a los trabajadores.

Agradecemos la invitación de Fenrong Liu por esta oportunidad tan enriquecedora para continuar pensando la inteligencia artificial desde una perspectiva crítica, situada y verdaderamente global, que no reproduzca narrativas únicas ni estereotipos heredados y que ponga en el centro a las personas.